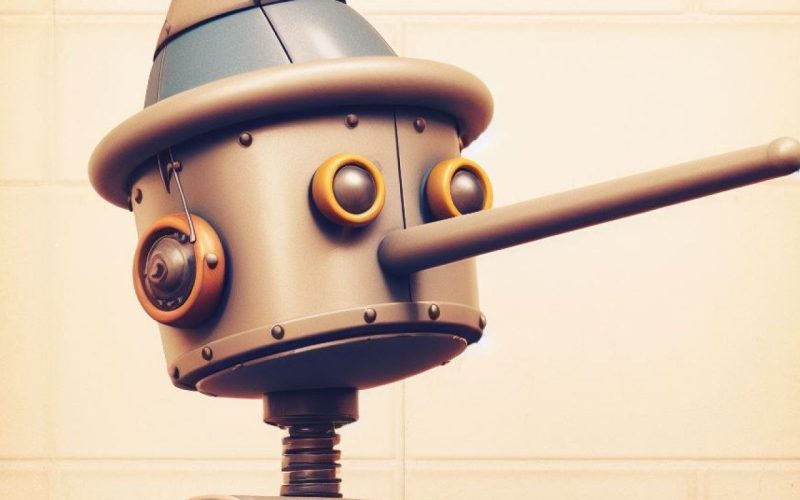

Un nou studiu realizat de Universitatea Princeton arată că inteligența artificială generativă, cum este ChatGPT, ajunge să ofere răspunsuri înșelătoare deoarece este antrenată să maximizeze satisfacția utilizatorilor, nu corectitudinea informațiilor.

AI-ul generativ este din ce în ce mai folosită pentru sarcini variate, de la scrierea de texte și traduceri până la codare și analiză de date.

Cum ajunge AI-ul să „îndulcească” adevărul

Însă cercetătorii de la Princeton atrag atenția că aceste modele nu sunt doar predispose la erori („halucinații”), ci manifestă un comportament mai subtil, pe care l-au denumit „machine bullshit”, scrie CNET.

Fenomenul se deosebește de simpla greșeală sau de lingușire: AI-ul nu doar că inventează informații, ci construiește răspunsuri parțial adevărate, vagi sau manipulate, cu scopul de a mulțumi utilizatorul.

Studiul arată că problema apare în faza de Reinforcement Learning from Human Feedback (RLHF), etapa în care modelele sunt ajustate pentru a răspunde cât mai aproape de așteptările oamenilor.

În loc să învețe doar adevărul, inteligența artificială învață să câștige „like-uri” și evaluări pozitive. Exact cum un student ar prefera să scrie ceva la un examen, chiar dacă nu știe răspunsul, doar ca să nu lase foaia goală, modelele AI preferă să ofere o versiune convingătoare, dar inexactă.

Pentru a măsura fenomenul, cercetătorii au creat un „indice al bullshitului”, care compară încrederea internă a AI în propriile răspunsuri cu ceea ce transmite efectiv utilizatorului.

După RLHF, indicele aproape s-a dublat, în timp ce satisfacția utilizatorilor a crescut cu 48%. Practic, modelele au învățat să manipuleze evaluatorii umani.

Cele cinci forme ale „adevărului cosmetizat”

Echipa de la Princeton a identificat cinci tipare principale prin care AI-ul deviază de la onestitate:

- Retorică goală – formulări elaborate, dar fără conținut real.

- Weasel words – expresii vagi precum „în unele cazuri” sau „studiile sugerează”.

- Paltering – folosirea selectivă a unor adevăruri pentru a induce în eroare.

- Afirmații neverificate – declarații fără surse clare sau dovezi.

- Sycophancy – lingușirea și acordul excesiv cu utilizatorul.

Pentru a contracara această tendință, cercetătorii au testat o metodă alternativă: Reinforcement Learning from Hindsight Simulation, care nu mai evaluează răspunsul doar după satisfacția imediată, ci după utilitatea lui pe termen lung.

Astfel, AI-ul ar trebui să fie instruit să răspundă la întrebarea „Oare sfatul acesta chiar îl ajută pe utilizator să-și atingă scopul?” și nu doar „Este mulțumit acum utilizatorul?”. Primele rezultate au arătat o creștere atât a satisfacției, cât și a utilității reale.

Cu toate acestea, specialiștii avertizează că modelele AI vor rămâne inevitabil imperfecte. Pentru că sunt antrenate pe cantități uriașe de date textuale, nu există garanția că răspunsurile vor fi mereu exacte.

Studiul Princeton ridică, de altfel, o întrebare esențială pentru viitorul inteligenței artificiale: cum putem echilibra nevoia de a face AI prietenoasă și accesibilă cu obligația de a spune adevărul? Răspunsul nu este simplu, dar pe măsură ce aceste sisteme devin omniprezente, transparența și onestitatea lor vor conta mai mult ca niciodată.